1. 의사결정나무 모델 개요

- 데이터에 내재되어 있는 패턴을 변수의 조합으로 나타내는 예측/분류 모델을 나무의 형태로 만드는 것

- 질문을 던져서 맞고 틀리는 것에 따라 우리가 생각하고 있는 대상을 좁혀나감

3단계로 이루어진다.

- Data: Input X, Output Y로 이루어진 Label 데이터

- Algorithm: 데이터를 2개 혹은 그 이상의 부분집합으로 분할(데이터가 균일해지도록)

- 분류: 비슷한 범주를 가진 관측치끼리 모음

- 예측: 비슷한 수치를 가진 관측치끼리 모음

- Model(Output): Node로 이루어짐

- Root node: 뿌리 마디

- Terminal node: 끝 마디(끝 마디 밑에는 더이상 분포하지 않는다)

- Intermediate node: 중간 마디

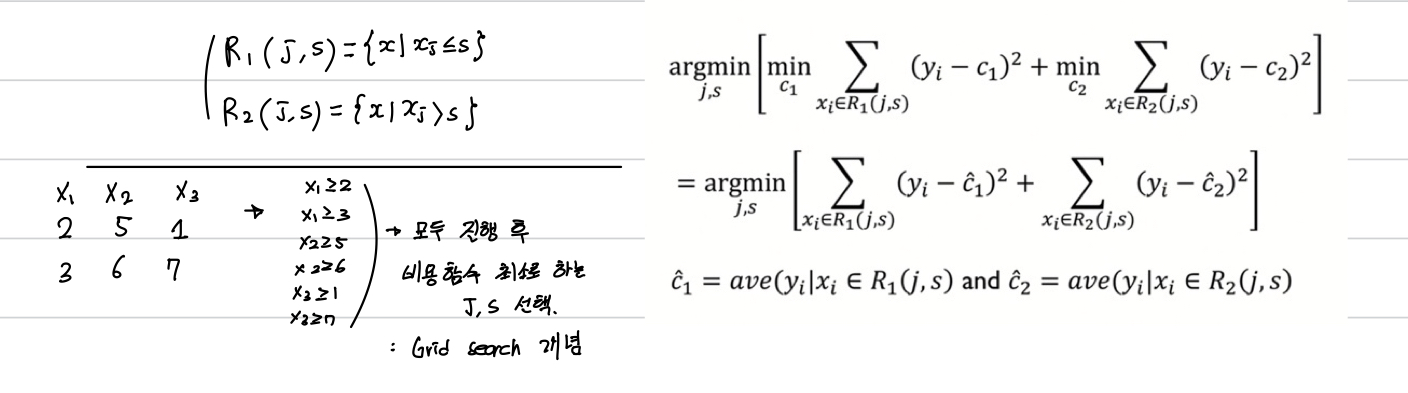

2. 예측나무 모델(Regression Tree)

예측문제에서의 Y값은 범주가 아닌 숫자값이다.

3. 예측나무 모델링 프로세스

4. 분류나무 모델

5. 분류나무 모델링 프로세스

분류모델에서는 Y가 실제 값이 아닌 범주이기에 불순도를 측정하는 비용함수로 나타낸다.

분할법칙

- 분할변수와 분할기준은 목표변수의 분포를 가장 잘 구별해주는 쪽으로 정함

- 목표변수의 분포를 잘 구별해주는 측도로 순수도 또는 불순도를 정의

- 예를 들에 클래스 0과 클래스 1의 비율이 455와 55%인 노드는 각 클래스 비율이 90%와 10%인 마디에 비해 불순도가 높다(또는 순수도가 낮다)라고 해석

- 각 노드에서 분할변수와 분할점의 설정은 불순도의 감소가 최대가 되도록 선택(불순도의 식이 비용 함수이다)

6. Information Gain

각 변수의 중요도 계산

7. 개별 트리 모델의 단점

- 계층적 구조로 인해 중간에 에러가 발생하면 다음 단계로 에러가 계속 전파

- 학습 데이터의 미세한 변동에도 최종 결과 크게 영향

- 적은 개수의 노이즈에도 크게 영향

- 나무의 최종노드 개수를 늘리면 과적합 위험(Low Bias, Large Variance)

해당 내용은 고려대학교 산업경영공학과 김성범 교수님의 핵심 머신러닝 유튜브를 바탕으로 작성된 글입니다.